GCP(Google Cloud Platform)のLinux仮想マシン上で、GCS(Google Cloud Storage)とBigQueryで連動するPython 2.7のプログラムを動かせるようにしてみたので、その手順を共有する。

前提条件

GCP(Google Cloud Platform)のアカウントが有り、下記記事の手順に従って、GCP上でDebian GNU/Linux搭載済の仮想マシンを作成済であること

また、以下の記事での環境構築を実施済であること

やってみたこと

- pipパッケージのインストール

- google-cloud-storageパッケージのインストール

- google-cloud-bigqueryパッケージのインストール

- Pythonプログラムの配置

- Pythonプログラムの実行

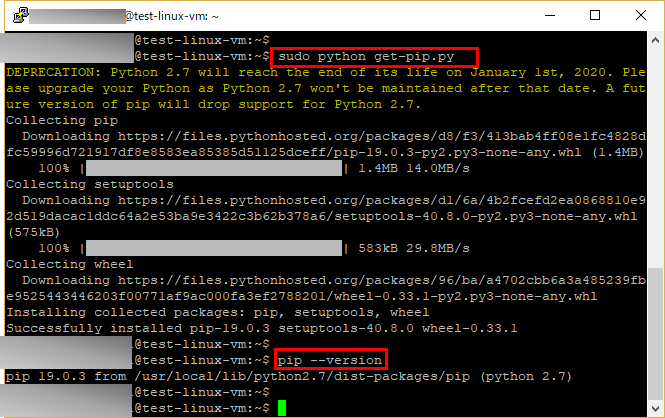

pipパッケージのインストール

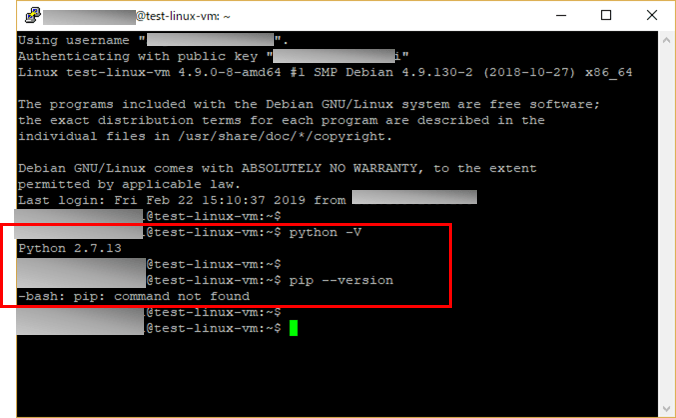

Pythonでは、パッケージのインストールを簡単にするためにpipというパッケージ管理ツールが用意されているが、Debian GNU/Linux搭載済の仮想マシンを作成した時点では、pipパッケージがインストールされていない。そのため、pipパッケージのインストールを行う。

1) pipパッケージをインストールする前の状態は以下の通り

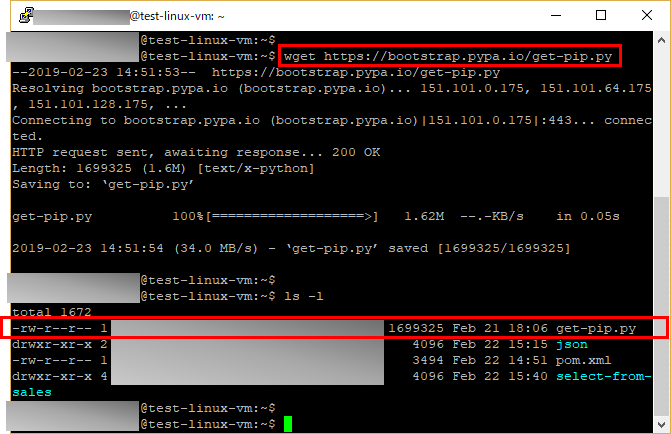

2) 「wget https://bootstrap.pypa.io/get-pip.py」を実行し、get-pip.pyというファイルを取得

3) 「sudo python get-pip.py」を実行し、pipパッケージのインストールを実施

その後、「pip –version」を実行し、pipパッケージのバージョンを確認

google-cloud-storageパッケージのインストール

GCSを利用するためのライブラリである、google-cloud-storageパッケージのインストールを行う。

1) 「sudo pip install google-cloud-storage」を実行し、google-cloud-storageパッケージのインストールを実施

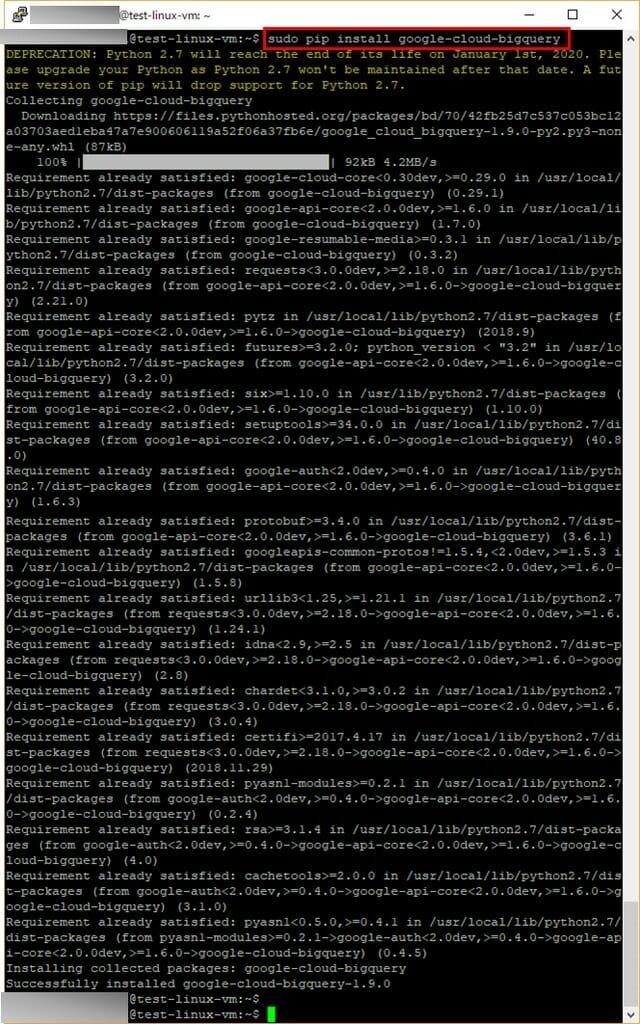

google-cloud-bigqueryパッケージのインストール

BigQueryを利用するためのライブラリである、google-cloud-bigqueryパッケージのインストールを行う。

1) 「sudo pip install google-cloud-bigquery」を実行し、google-cloud-bigqueryパッケージのインストールを実施

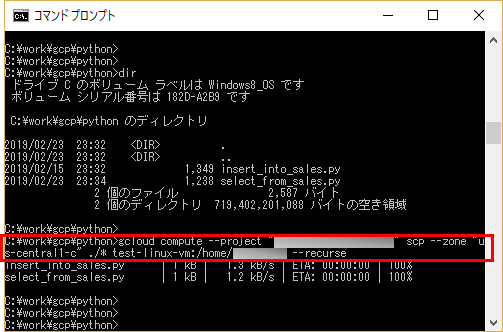

Pythonプログラムの配置

Pythonプログラムを、Debian GNU/Linux搭載済の仮想マシン上に配置する。なお、下記手順のプログラムの作成とgcloudコマンドによるコピーは、Windows10のローカルPC上で実施している。

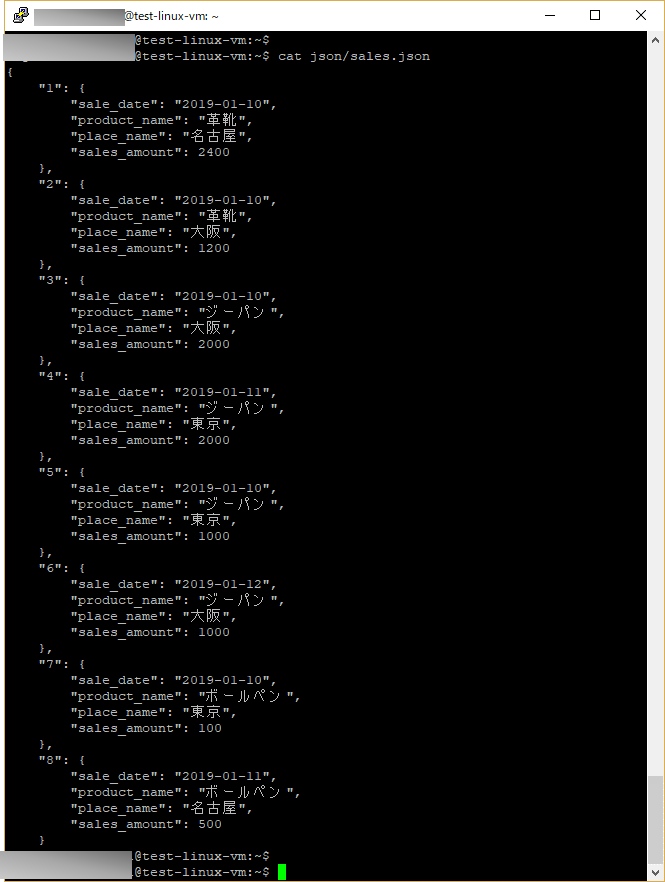

1) Pythonプログラム(insert_into_sales.py、select_from_sales.py)は、select_from_sales.pyのJSON出力先となるファイルパスを「”/home/ユーザーID/json/sales.json”;」と変更する以外は、下記記事と同じ内容とする。

2) コマンドプロンプト上で、「gcloud compute –project “プロジェクトID” scp –zone “ゾーン名” ./コピーファイル名 仮想VMインスタンス名:/home/ユーザー名 –recurse」を入力し、ローカルPCのファイルをDebian GNU/Linux搭載済の仮想マシンにコピーする

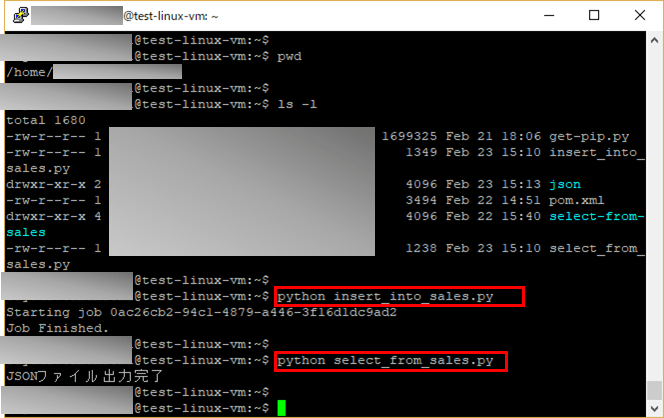

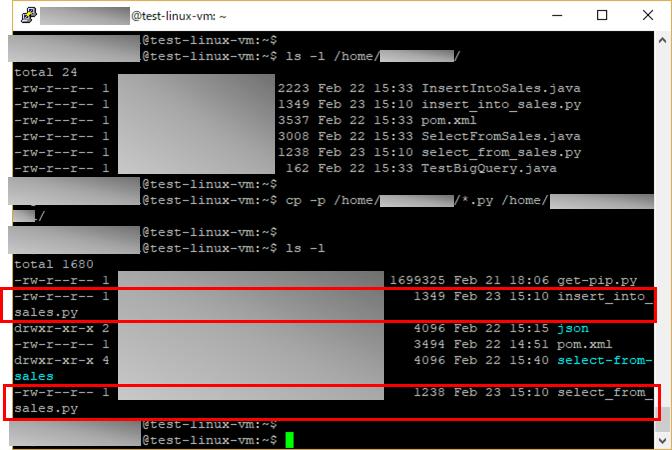

3) 下図のように、Debian GNU/Linux搭載済の仮想マシン上に、Pythonプログラムをコピーする

Pythonプログラムの実行

Pythonプログラムを実行する。